OpenAI starebbe collaborando con i DEM per controllare ciò che la sua intelligenza artificiale, come ChatGPT, possa dire prima di rilasciarla al pubblico.

L’azienda starebbe lavorando a stretto contatto con il governo e le grandi aziende tecnologiche per limitare l’accesso a certe informazioni, o per censurare contenuti ritenuti problematici. Ci sono anche preoccupazioni sul fatto che dipendenti o ricercatori che sollevano questioni su potenziali rischi dell’AI possano essere messi a tacere o puniti. In sostanza, si teme che l’AI venga utilizzata in modo da “prevenire” o “smentire” alcune informazioni, limitando la libertà sia di informazione che di espressione.

Un gruppo di legislatori ha richiesto al CEO di OpenAI, Sam Altman, di fornire dati sui piani dell’azienda per garantire la sicurezza e il rispetto degli impegni in tema di sicurezza dell’intelligenza artificiale (AI), a seguito di preoccupazioni riguardo alla tecnologia e ai protocolli di sicurezza adottati dall’azienda.

I senatori, guidati dal senatore Brian Schatz (D-HI), hanno scritto una lettera a Altman chiedendo che si impegni a rendere disponibile il prossimo modello fondamentale di AI per test, revisione, analisi e valutazione da parte delle agenzie governative degli Stati Uniti prima del suo impiego.

“Chiediamo ulteriori informazioni a OpenAI sui passi che l’azienda sta facendo per rispettare gli impegni pubblici sulla sicurezza, su come sta valutando internamente i progressi su tali impegni e sull’identificazione e la mitigazione delle minacce alla cybersicurezza”, si legge nella lettera.

Sam Altman, CEO di OpenAI, ha dichiarato che l’azienda sta lavorando su strumenti per monitorare e classificare i progressi nello sviluppo dell’intelligenza artificiale, con l’obiettivo di tenere traccia dei risultati e dei miglioramenti nel campo. Reclaim the Net ha messo in dubbio questa affermazione, chiedendo “chi sono esattamente i tuoi stakeholder, Altman?”.

In altre parole, Reclaim the Net, solleva il dubbio sul fatto che Altman non abbia specificato chi siano queste persone o organizzazioni coinvolte nel processo di valutazione dell’IA. La domanda implica una preoccupazione per la trasparenza, chiedendo se queste “parti interessate” siano davvero rappresentative della società o se ci sia una concentrazione di potere nelle mani di pochi, come grandi aziende o governi.

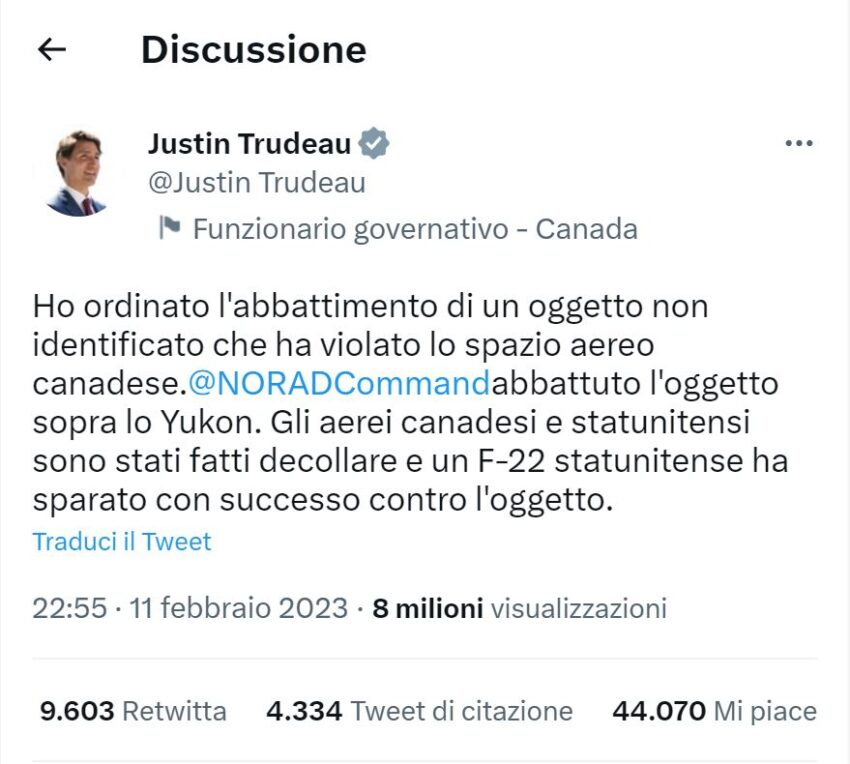

Inoltre, è emerso che OpenAI ha recentemente nominato Paul M. Nakasone, ex direttore della NSA (National Security Agency), come membro del suo consiglio di amministrazione. Questo ha sollevato interrogativi su un possibile legame tra il governo e le grandi aziende tecnologiche, alimentando preoccupazioni riguardo alla censura e alla “pre-bunking” delle informazioni a cui i cittadini avranno accesso.

A luglio, dei whistleblower di OpenAI avevano scritto una lettera alla Securities and Exchange Commission, accusando l’azienda di aver emesso accordi di non divulgazione e di cessazione del rapporto di lavoro restrittivi, potenzialmente penalizzando i dipendenti che volevano sollevare preoccupazioni presso le autorità federali.

In una dichiarazione rilasciata al Washington Post, un portavoce di OpenAI, Hannah Wong, ha affermato che l’azienda ha “apportato modifiche significative al processo di separazione per rimuovere le clausole di non denigrazione dagli accordi con i dipendenti”.

Nel frattempo, i colossi tecnologici Microsoft e Apple hanno scelto di non unirsi al consiglio di OpenAI, nonostante l’investimento da 13 miliardi di dollari di Microsoft nell’azienda nel 2023. Questa decisione è arrivata dopo le lamentele sulla crescente complessità della supervisione dell’AI e l’aumento dell’attenzione da parte dei regolatori.

Inoltre, William Saunders, ex dipendente di OpenAI, ha recentemente dichiarato di aver lasciato l’azienda per timore che la sua ricerca potesse rappresentare una seria minaccia per l’umanità. Sebbene le sue preoccupazioni non siano riferite alla versione attuale di ChatGPT, teme le future versioni e lo sviluppo di un’AI che potrebbe superare l’intelligenza umana. Crede che i lavoratori dell’AI debbano avvertire il pubblico riguardo a sviluppi potenzialmente pericolosi.

Se l’intelligenza umana regredisce sempre di piu’, l’Intelligenza

Artificiale rischia di sembrare unica forma pensante sulla terra.

Sta in noi bloccare questo giochino perverso in forma diretta

e non per vie trasversali. Paghiamo le tasse per cosa ? ci stanno

fregando mantenendo buono il popolo con le chiacchere.