L’utilizzo del sistema basato sull’intelligenza artificiale denominato Habsora (il Vangelo, in inglese) da parte dell’IDF (Forze di Difesa Israeliane), durante l’offensiva sulla Striscia di Gaza ha sollevato gravi preoccupazioni e critiche. Questo sistema, definito come una “fabbrica di bersagli”, sembra essere stato impiegato in modo indiscriminato, aumentando il rischio di colpire civili e infrangendo il diritto internazionale umanitario.

L’IDF sostiene che “Il Vangelo” produce raccomandazioni di bersagli in modo rapido ed efficiente, ma il processo sembra dare priorità alla quantità di bersagli piuttosto che verso una valutazione accurata della legittimità di ciascun obiettivo. Gli obiettivi vengono preparati automaticamente dall’IA senza un’approfondita analisi umana, dando luogo a una sorta di produzione di “bersagli a catena”. L’accelerazione di questo processo solleva domande sul controllo umano effettivo e sulla capacità di valutare in modo critico le raccomandazioni del sistema.

L’utilizzo di un “punteggio” nel sistema “Il Vangelo” per valutare il numero di “vittime civili accettabili” è profondamente inquietante e solleva gravi preoccupazioni sulla condotta etica dell’IDF durante il conflitto. Questo approccio indica un calcolo freddo e spietato di ciò che viene indicato come “danni collaterali”, contravvenendo agli obblighi etici e legali di proteggere la vita civile durante i conflitti armati.

Un funzionario, che ha lavorato sulle decisioni di puntamento nelle precedenti operazioni a Gaza, ha detto che l’IDF non aveva mai preso di mira le case dei membri minori di Hamas per i bombardamenti. Ha detto di ritenere che ciò sia cambiato per l’attuale conflitto, con le case dei sospetti agenti di Hamas ora prese di mira indipendentemente dal grado.

“Sono molte case”, ha detto il funzionario.

“I membri di Hamas che non contano nulla vivono nelle case di tutta Gaza. Così segnano la casa, la bombardano e uccidono tutti i presenti”.

Agli obiettivi viene assegnato un “punteggio” per il probabile numero di vittime civili

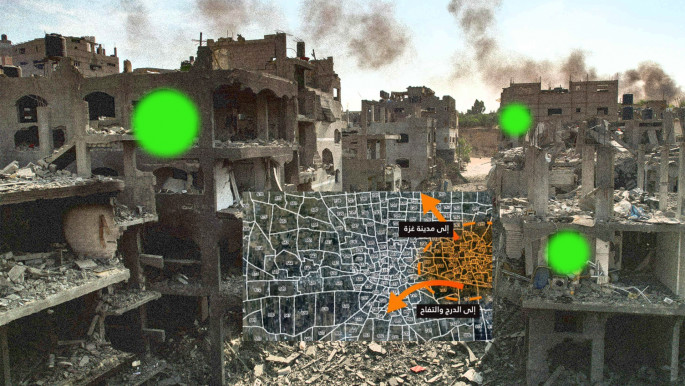

All’inizio di novembre, l’IDF ha dichiarato che la sua divisione di amministrazione degli obiettivi aveva individuato “più di 12.000” obiettivi a Gaza. Nel descrivere il processo di individuazione degli obiettivi dell’unità, un funzionario ha affermato:

“Lavoriamo senza compromessi per definire chi e cosa sia il nemico. Gli operatori di Hamas non sono immuni – non importa dove si nascondano”.

Un’ex fonte militare israeliana di alto livello ha dichiarato a TheGuardian, un noto quotidiano britannico, che gli agenti utilizzano una misurazione “molto accurata” del tasso di civili che evacuano un edificio poco prima di un attacco.

“Usiamo un algoritmo per valutare quanti civili sono rimasti. Ci dà un verde, un giallo, un rosso, come un segnale stradale”.

Nonostante le affermazioni dell’IDF riguardo alle precauzioni prese per ridurre i danni ai civili, esperti di IA e diritto internazionale umanitario sollevano dubbi sulla reale precisione e restrizione nell’uso della forza. La rapidità con cui vengono identificati e colpiti gli obiettivi mette a rischio la vita di numerosi civili, creando un contesto in cui l’intelligenza artificiale contribuisce a una spirale di violenza indiscriminata.

L’IDF ha dichiarato che “Il Vangelo” viene utilizzato per estrarre rapidamente informazioni e fornire raccomandazioni sul bersaglio, con l’obiettivo di garantire una completa corrispondenza tra la raccomandazione della macchina e l’identificazione effettuata da una persona. Secondo diverse fonti informate sui processi di targeting dell’IDF, “Il Vangelo” è stato impiegato per generare raccomandazioni automatiche per attaccare obiettivi, tra cui le abitazioni private di individui sospettati di essere operatori di Hamas o della Jihad islamica.

Negli ultimi anni, la divisione obiettivi dell’IDF ha contribuito a creare un database contenente tra 30.000 e 40.000 sospetti militanti. Sistemi avanzati come “Il Vangelo” sono stati identificati come cruciali nella compilazione di elenchi di autorizzazioni per assassinare individui sospetti. Recentemente, si è verificato un evento significativo in cui un commando guidato dall’intelligenza artificiale ha effettuato un’incursione in un ospedale per eliminare un sospetto militante legato alla Jihad islamica. Quest’ultimo, ricoverato in stato di coma da tre mesi, è stato ucciso dal commando, colpito alla testa con un’arma silenziata.

Aviv Kochavi, che è stato a capo dell’IDF fino a gennaio, in un’intervista pubblicata prima della guerra, ha dichiarato che si tratta di

“una macchina che produce grandi quantità di dati in modo più efficace di qualsiasi umano e li traduce in obiettivi da attaccare”.

Secondo Kochavi, “una volta che questa macchina è stata attivata” nella guerra di 11 giorni di Israele contro Hamas nel maggio 2021, ha generato 100 obiettivi al giorno.

“Per metterlo in prospettiva, in passato producevamo 50 obiettivi a Gaza all’anno. Ora, questa macchina produce 100 obiettivi al giorno, il 50% dei quali viene attaccato”.

Un ex funzionario della Casa Bianca, esperto nell’utilizzo di sistemi autonomi da parte dell’esercito statunitense, ha affermato che molti paesi stanno seguendo attentamente e apprendendo dalle attuali pratiche militari di Israele, che coinvolgono l’uso di sistemi autonomi. L’utilizzo diffuso dell’intelligenza artificiale da parte dell’esercito israeliano per prendere decisioni sui bersagli nella guerra contro la Palestina solleva gravi preoccupazioni.

La pericolosa prospettiva in cui un’intelligenza artificiale possa decidere la vita e della morte delle persone coinvolte in conflitti rappresenta un’allarmante deriva. Consegnare le decisioni vitali a sistemi autonomi innalza gravi interrogativi etici e morali, richiedendo un’esame critico delle profonde implicazioni che ciò comporta. La possibilità che l’IA detti il destino umano, oltre a essere inquietante, sottolinea la necessità di una riflessione urgente e approfondita sulle gravi conseguenze umane e sociali dietro l’impiego di tali tecnologie in contesti già così drammatici.

ogni giorno dovrebbe essere quello della memoria per il popolo Israeliano.

Stanno dimenticando da dove arrivano …………..